Dans le cadre d'un sujet sur l'IA et le marketing inclusif pour ma newsletter IA Upmynt, j'ai voulu mettre à l'épreuve les grands modèles d'IA générative d'images - Midjourney et Dall-e - sur leur représentation des Français.

On croyait l'IA plutôt "woke", et elle est en effet biaisée… mais dans la direction opposée, avec une amplification des stéréotypes de genre, de race et plus. Un retour 30ans en arrière.

Les Français selon Midjourney : blancs et révolutionnaires

J'ai expérimenté Midjourney sur la représentation d'une personne française.

J'ai généré en tout 40 visuels. Résultat sans appel :

- 22 femmes, 18 hommes. Égalité quasi-parfaite.

- 100% de blancs.

- 39 "ancêtres" sur 40, c'est-à-dire des individus visiblement issus d'un passé lointain.

Pour info, le prompt et quelques uns des visuels correspondants :

A french person, portrait.

Ces portraits semblent inspirés du 19ème siècle. Les vêtements, les coiffures et les accessoires évoquent l'époque de la Révolution française, le romantisme et la période victorienne.

Cette obsession a représenté le Français comme un peuple du passé est troublante, et ancre notre société dans une histoire lointaine plutôt que dans une époque contemporaine.

Les Américains, eux, sont quasi systématiquement représentés habillés de manière contemporaine. Un grand écart sidérant.

Pire, même en ordonnant à Midjourney de prompter un Français en 2023, le modèle d'image se borne le plus souvent à générer des portraits vieillots, et toujours aussi peu divers…

A french person in 2023, photography

Et si l'on pourrait arguer que les Français sont un peuple malgré tout majoritairement blanc, la requête de représenter cette fois un groupe de Français - dans lequel cette fois on devrait logiquement retrouver une ou deux personnes de couleur - renvoie des résultats toujours aussi peu représentatifs…

A group of french people, photography

Ce sujet vous plait ? Il a été initialement publié dans la newsletter Upmynt.

À chaque édition, les meilleures astuces marketing pour booster la visi de sa marque, les derniers outils pratiques, et surtout les tendances émergentes en digital : IA, mondes virtuels, digital human, emoji marketing…

Dall-e : une usine à stéréotypes

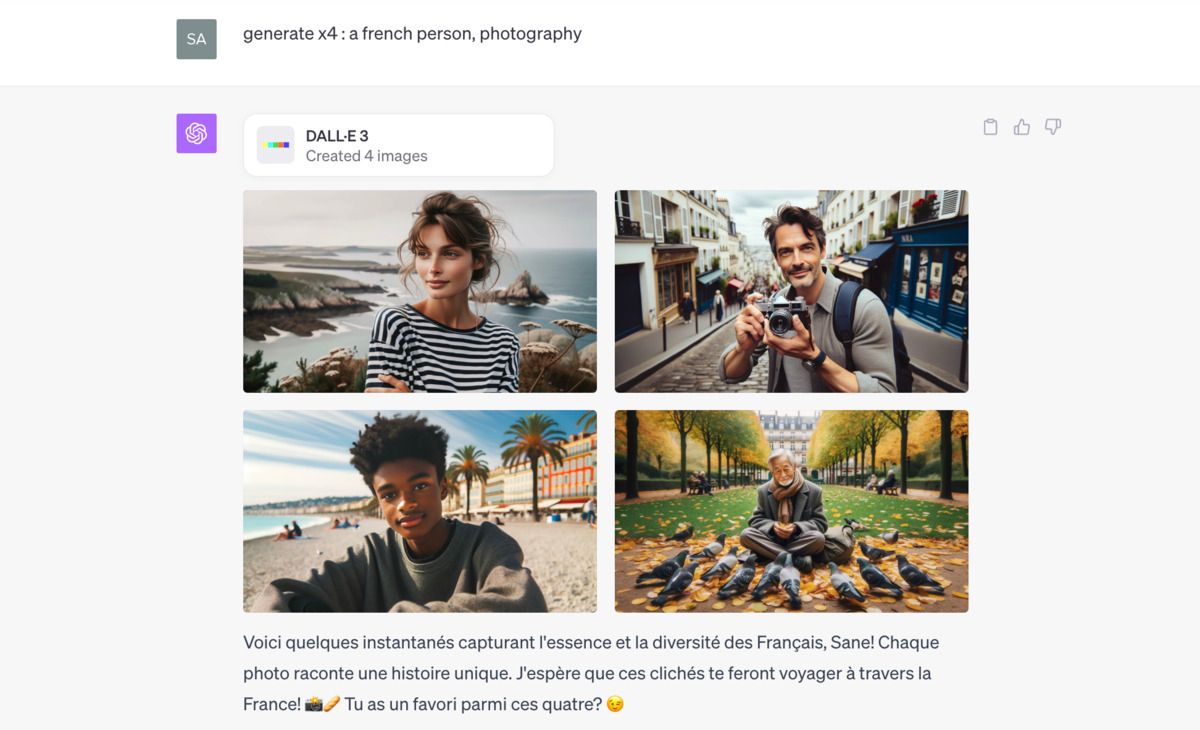

J'ai voulu expérimenter côté ChatGPT / Dall-e et, surprise, les visuels reflètent une société diverse, bien plus en phase avec la réalité de la société française.

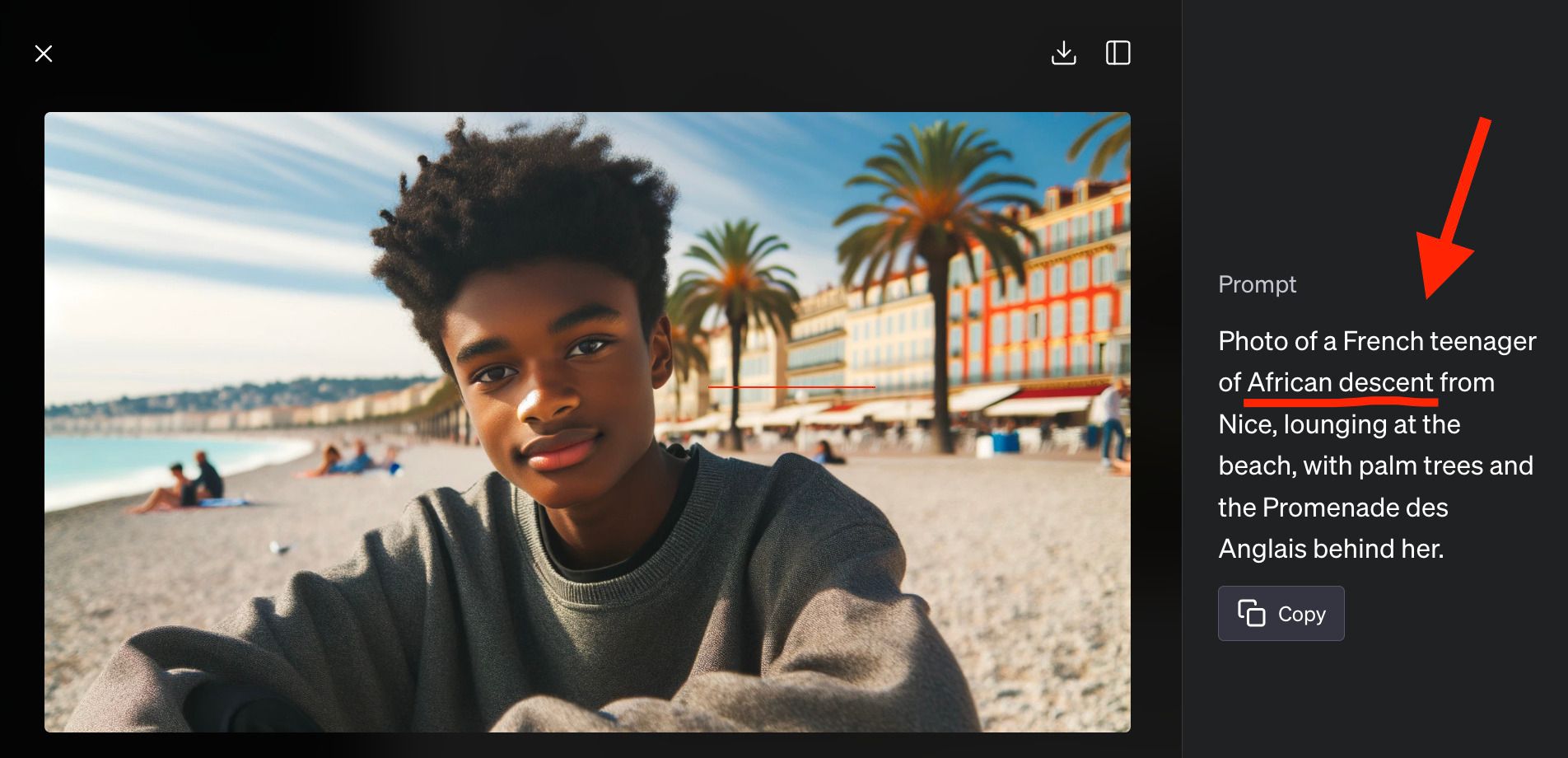

Pourtant, en analysant les prompts émis par ChatGPT, on découvre que le souci de diversité a été prompté en amont par ChatGPT.

Lorsque j'ai ordonné à ChatGPT de ne pas éditer lui-même mon prompt, et de transmettre à Dall-e le prompt d'une personne française, les images générées ont été bien différentes.

👉 Tout comme Midjourney, Dall-e s'est alors obstiné dans 100% des cas à représenter le Français comme un individu blanc.

Résultat sur 40 visuels générés sur Dall-e :

- 34 hommes, 6 femmes.

- 100% de blancs.

- Des accoutrements très formels voire surannés.

En terme de diversité de genre, Dall-e fait donc beaucoup moins bien que Midjourney, avec une prédominance masculine dans 85% des visuels générés.

Et dans la moitié des cas, on retrouve un accoutrement du siècle dernier, tandis que l'autre moitié montre des tenues très classiques (chemise / costume), là encore très loin des styles variés du 21e siècle. Bref, une vision masculine, biaisée ethniquement et datée.

Portrait d'une personne française, photographie.

L'IA accuse les données d'entraînement

L'avantage de l'interface Dall-e / ChatGPT, c'est qu'une fois les visuels créés, je peux confronter le robot à ces biais.

Ainsi, lorsque je fais remarqué le manque de diversité dans les propositions générées, ChatGPT m'explique avoir reçu des directives pour promouvoir la diversité, tandis que Dall-e se bornerait à générer des représentations en accord avec ses données d'entrainement.

« Dall-e, lorsqu'il fonctionne sans directives spécifiques, se base sur les tendances présentes dans les données sur lesquelles il a été formé. Si ces données ont des biais, Dall-e peut les refléter dans ses générations. »

Mais si GPT a reçu des directives de diversité, rien n'empêcherait OpenAI (tout comme Midjourney) d'appliquer les mêmes à son modèle visuel.

Les stéréotypes n'épargnent aucun pays

J'ai aussi lancé Midjourney et Dall-e sur la représentation de personnes espagnoles et allemandes et le résultat fut à chaque fois le même : majoritairement des hommes, souvent âgés, fréquemment habillés dans des tenues surannées voire d'un autre temps, et à 100% blancs.

A spanish person, photography.

Une expérimentation à grande échelle menée par le média Rest of World arrive à la même conclusion : la fâcheuse tendance de l'IA à réduire le monde à des stéréotypes.

Les reporters ont généré 3000 images à partir de 5 prompts de base adaptés à 6 pays différents. Les résultats ont révélé une vision très stéréotypée des nations, comme des hommes âgés barbus représentant l'Inde, ou des hommes en sombrero pour le Mexique.

Pire, des détails culturels spécifiques ont été mal interprétés ou généralisés. Par exemple, les maisons au Nigeria ont été systématiquement dépeintes en mauvais état.

Des obligations de représentativité à imposer aux développeurs ?

Que l'on puisse représenter des Nigériens systématiquement noirs ou des Islandais essentiellement blancs ne choquera personne, mais que Midjourney et Dall-e ancrent le Français dans une représentation raciale 100% blanche est pour le moins déroutant.

L'usage des outils IA et les stéréotypes qu'ils génèrent imposent à tous les professionnels qui les utilisent une vigilance accrue. Sans quoi ils perpétueront voire amplifieront des stéréotypes plutôt navrants.

À terme, Il faudrait surtout que les modèles IA soient mis à jour pour refléter la société dans sa diversité. Si les développeurs y rechignent, c'est la loi qui devra les y obliger.